437 Просмотров

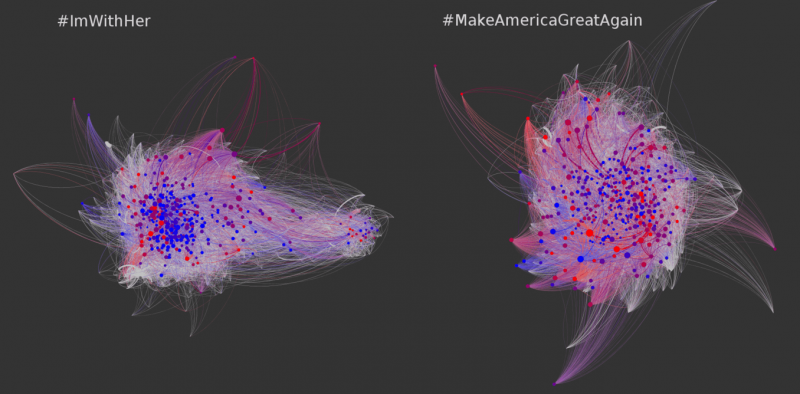

Как распространялись предвыборные новости по хэштегам #ImWithHer (за Хиллари Клинтон) и #MakeAmericaGreatAgain (за Дональда Трампа): точками обозначены твиттер-аккаунты, линии между ними изображают ретвиты. Диаметр точек зависит от количества ретвитов, произведенных аккаунтом. Красным цветом помечены аккаунты, которые с высокой степенью вероятности являются ботами, голубым — аккаунты реальных пользователей.

Если вы получаете новости из социальных медиа, как и делают большинство американцев, вы подвержены суточной дозе мистификаций, слухов, теорий заговора и вводящей в заблуждение новости. Когда все это смешивается с достоверной информацией из честных источников, правда может быть очень трудно различить.

На самом деле, анализ моей исследовательской группы данных из Колумбийского университета Эмерджентный слух трекера предполагает, что это дезинформация столь же вероятно, вирусный, как достоверной информации.

Многие спрашивают, является ли этот натиск цифровой дезинформации повлияло на исход из 2016 года выборах в США. Правда, мы не знаем, хотя есть основания полагать, что это вполне возможно, на основе прошлого анализа и счетов из других стран. Каждая часть дезинформации способствует формированию наших мнений. В целом, вред может быть очень реальным: Если люди могут быть обманут в ставит под угрозу жизнь наших детей, как они делают, когда они выбирают из вакцинаций, почему бы не нашу демократию?

Как исследователь распространения дезинформации через социальные медиа, я знаю, что ограничивающая способность «новостных обманщиков», чтобы продавать рекламу, как недавно объявленные Google и Facebook, является шагом в правильном направлении. Но это не будет пресекать злоупотребления, порождённые политическими мотивами.

Эксплуатация социальных медиа.

Около 10 лет назад, мои коллеги и я побежал эксперимент, в котором мы узнали 72 процентов студентов доверяют ссылки, которые появились происходят из друзей — вплоть до ввода персональной информации для входа на фишинговые сайты. Это широко распространенное уязвимость предложил другую форму вредоносных манипуляций: Люди могут также считают, дезинформации, которую они получают при нажатии на ссылку из социального контакта.

Чтобы изучить эту идею, я создал фальшивую веб — страницу со случайными, генерируемыми компьютером новостными сплетнями — такие вещи, как «Celebrity X поймали в постели с Celebrity Y!» Посетителей на сайте, которые искали имя будет запускать скрипт для автоматического изготовления рассказ о человеке. Я включил на сайте заявления об отказе, заявив, что сайт содержал бессмысленный текст и выдуманные факты «.» Я также разместил объявления на странице. В конце месяца, я получил чек по почте с доходов от рекламы. Это было мое доказательство: Поддельные новости могут делать деньги, загрязняя интернет фальшивками.

К сожалению, я не был единственным, с этой идеей. Десять лет спустя, мы имеем индустрию поддельных новостей и цифровой дезинформации. Clickbait сайтов производство мистификации, чтобы заработать деньги от рекламы, в то время как так называемые hyperpartisan сайты публиковать и распространять слухи и теории заговора, чтобы повлиять на общественное мнение.

Эта отрасль подкреплена, насколько легко создать социальных ботов, поддельные счета, контролируемые программным обеспечением, которые выглядят как настоящие люди, и поэтому могут иметь реальное влияние. Исследования, проведенные в моей лаборатории обнаружили много примеров поддельных низовыми кампаний, так называемые политические астротурфинги.

В ответ на это, мы разработали BotOrNot инструмент для выявления социальных ботов. Он не идеален, но достаточно точен, чтобы раскрыть убеждения кампаний в Brexit и antivax движениях. Используя BotOrNot, наши коллеги обнаружили, что большая часть слухов в интернете — болтовня о выборах 2016 года была создана ботами.

Создание информационных пузырей.

Людьми довольно легко манипулировать с помощью дезинформации в соцсетях, поскольку этому способствует сложное сочетание социальных, когнитивных, экономических и поведенческих установок, разделяемых всеми нами. Некоторые из них сыграли положительную роль в ходе эволюции: доверие к сигналам, исходящим от ближайшего окружения, и скептицизм по отношению к сведениям, противоречащим собственному опыту, помогли нашим предкам научиться избегать зубов хищников. Но в сегодняшнем замкнутом мире сетевого общения сигналы, поступающие ко мне из соцсети от сторонника теории заговора, проживающего на другом конце мира, мешают мне принимать взвешенные решения.

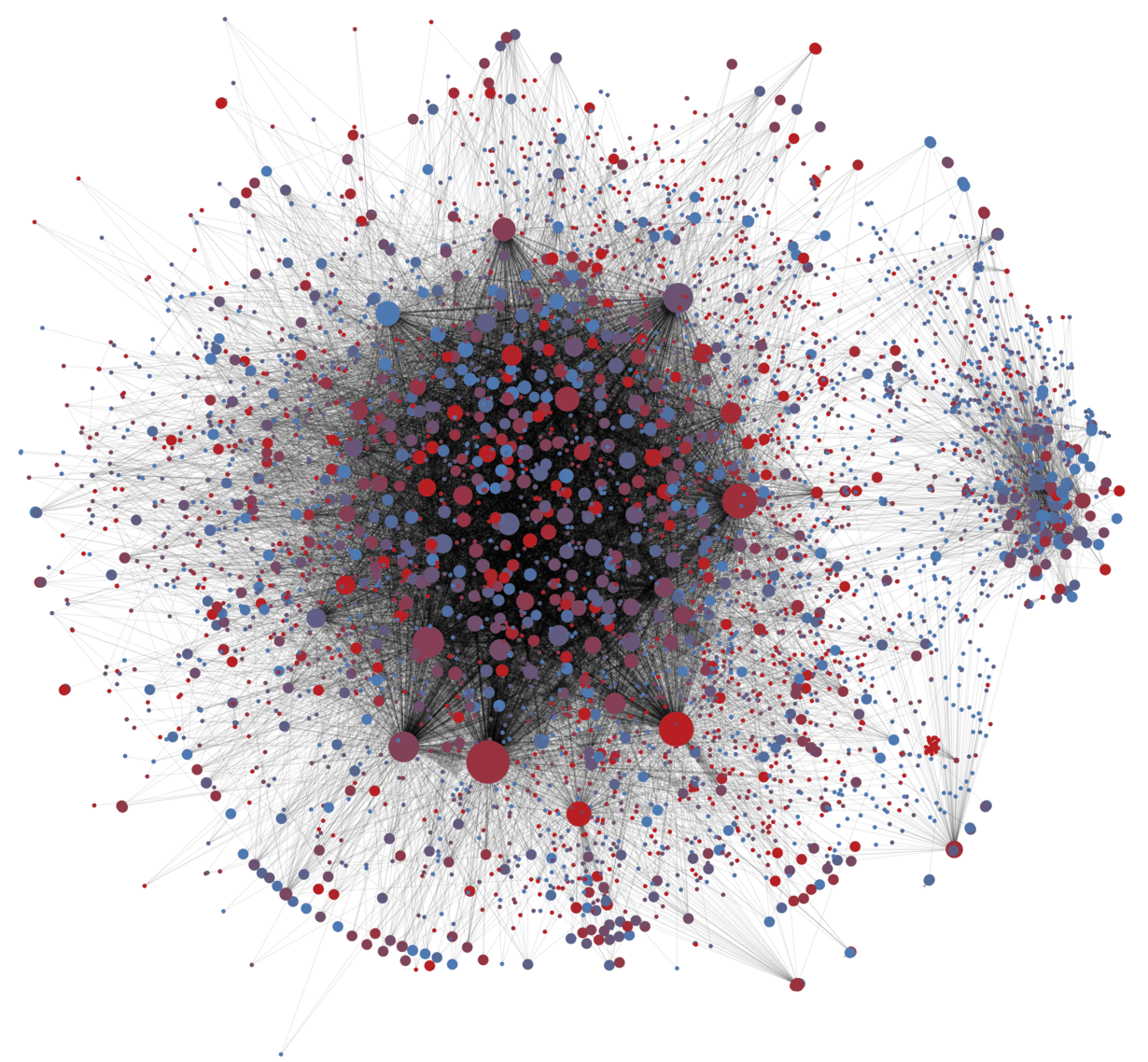

«Расшаривая» сообщения друзей и «отписываясь» о тех, чьи мнения отличаются от наших, мы оказываемся в настолько полярно ориентированной «эхокамере», что по одному списку ваших друзей исследователи с высокой точностью скажут, кто вы — либерал или консерватор. Структура социальной сети настолько плотная, что дезинформация внутри отдельной группы распространяется практически молниеносно, и в то же время настолько раздробленная, что другие группы о ней ничего не знают.

Внутри нашего «пузыря» мы получаем только специально отобранную информацию, совпадающую с нашими убеждениями. Такой сценарий идеален для повышения уровня общительности, но губителен для развития здорового скептицизма. Чрезмерная уверенность в своей правоте приводит к тому, что мы «расшариваем» заголовок, не читая самой статьи.

Наша лаборатория извлекла похожий урок на собственном опыте, когда в преддверии промежуточных выборов в Америке в 2014 году стала объектом злостной дезинформации. Изучая активность соцсетей, мы наткнулись на фальшивые сообщения о наших исследованиях, которые распространялись, преимущественно через твиттер, внутри односторонне ориентированной «эхокамеры» — большого, однородного и политически активного сообщества. Эти люди молниеносно ретвитили фальшивые сообщения, но были крайне скупы на опровержения.

Вирусная неизбежность.

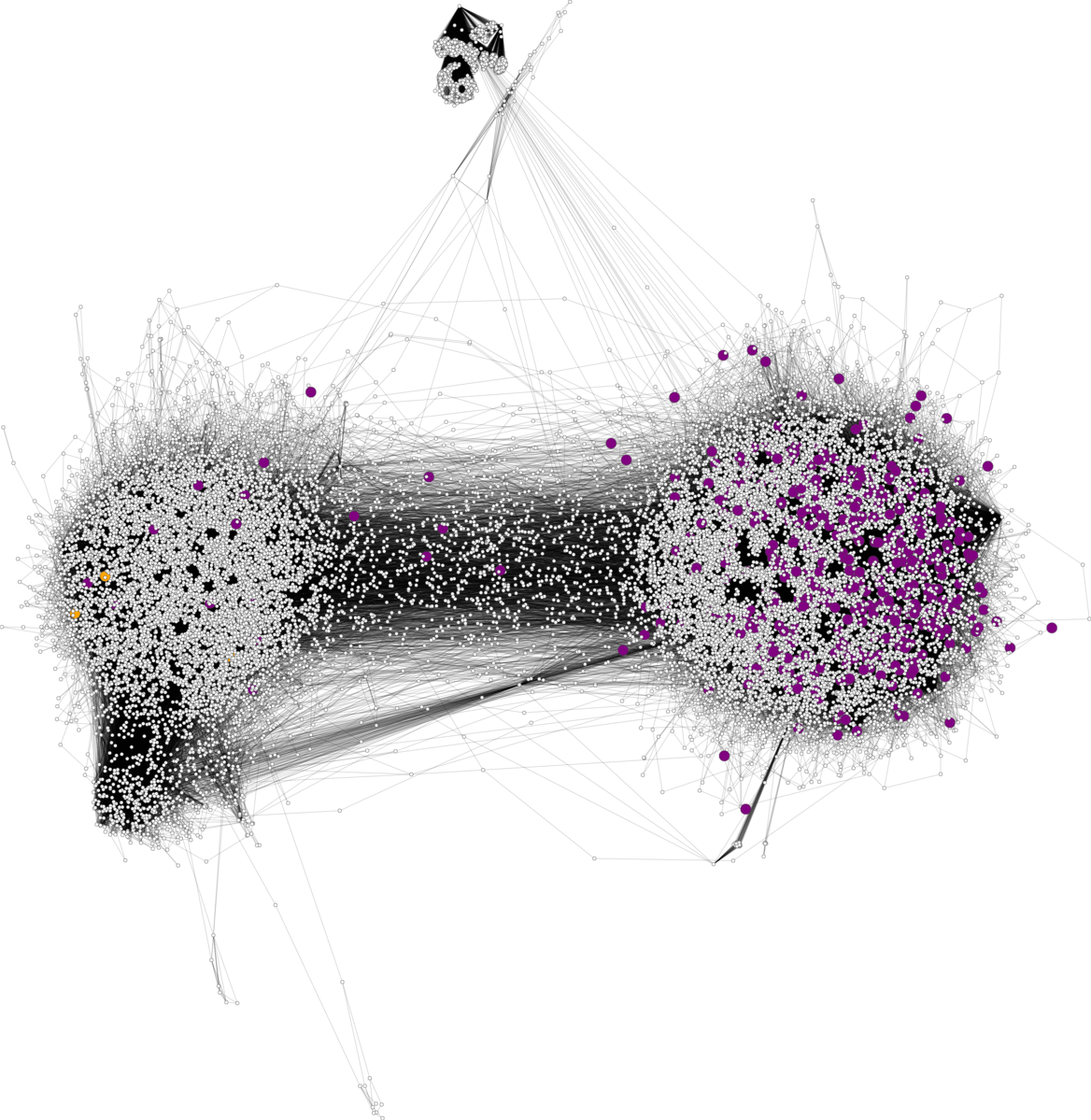

Наше исследование показывает, что при существующей структуре социальных сетей и ограниченном внимании пользователей некоторые мемы, независимо от их качества, неизбежно становятся вирусными. Пусть даже отдельные пользователи стараются делиться проверенной информацией, соцсеть в целом не способна отличить правду от фальшивки. Этим и объясняются все вирусные «фейки», гуляющие по интернету.

Об остальном позаботится «экономика внимания»: если какая-то тема выходит в топ, связанная с ней информация начинает производиться ускоренными темпами. При этом сфабриковать новость, выдав ее за факт, гораздо дешевле, чем добывать правдивую информацию. Причем фабриковать можно на любой вкус: консерваторы прочли, что папа Римский поддержал Трампа, либералы прочли, что он поддержал Клинтон. А на самом деле он не поддерживал никого.

Всё дело в алгоритмах.

Раз мы все равно не можем просмотреть все сообщения из информационной ленты, отбор того, что мы увидим, берут на себя алгоритмы. Алгоритмы, используемые в сегодняшних соцсетях, настроены присваивать высокий приоритет «цепляющим» постам — на которые мы с большей вероятностью кликнем, отреагируем, которыми, возможно, поделимся. Но недавние исследования показали, что страницы с намеренной дезинформацией получают такой же отклик и распространяются так же широко, как и настоящие новости.

Предвзятость алгоритмов, предпочитающих показывать «цепляющие» новости взамен правдивых, усиливает присущую нам предвзятость социального и когнитивного характера. В результате, переходя по ссылкам в социальных сетях, мы сами себе сужаем круг посещаемых ресурсов, делаем его более однородным, чем было бы в случае самостоятельного поиска информации в сети и переходе по самым популярным ссылкам.

Существующие исследования показывают, что «эхокамера» способна сделать попавших в нее людей более доверчивыми по отношению к непроверенным слухам. Но мы еще мало знаем о том, почему люди по-разному реагируют на конкретный «фейк»: одни делятся им немедленно, а другие сперва стараются его проверить.

Чтобы изучить это состязание между теми, кто бездумно «шерит», и теми, кто проверяет информацию, мы смоделировали искусственную социальную сеть. Тем самым мы надеемся разобраться в противоречивых данных о том, что в каких-то ситуациях проверка данных помогает остановить распространение фальшивого сообщения, а в каких-то — нет. Полученные нами предварительные результаты позволяют предположить, что чем более замкнуто сообщество тех, кто верит фальшивке, тем дольше она живет. И это относится не только к самой фальшивке, но и к социальной сети в целом.

Многие пытаются понять, что с этим делать дальше. Судя по недавнему заявлению Марка Цукерберга, Facebook уже испытывает возможные решения. А группа студентов предлагает просто помечать линки при «расшаривании» как «достоверные» или «недостоверные».

Какими-то возможными механизмами решения этой задачи мы пока не обладаем.К примеру, мы пока не можем научить искусственный интеллект отделять правду от лжи. Но мы можем создать алгоритм, который будет присваивать более высокий рейтинг ресурсам с лучшим показателем надежности.

Изучение распространения поддельных новостей.

Чтобы эффективнее бороться с новостными «утками», необходимо понять пути их распространения. Например, если выяснится, что за большую часть «фейков» ответственны боты, мы сконцентрируемся на их поиске. Если, напротив, все дело в «эхокамерах», то, возможно, нам следует разработать такие алгоритмы рекомендации новостей, которые не будут исключать разные точки зрения.

Поэтому наша лаборатория разрабатывает платформу Hoaxy, способную проследить и визуализировать пути распространения непроверенных и соответствующих им надежных сообщений в соцсетях. Эти данные, полученные из реального мира, мы загрузим в нашу искусственную соцсеть и тогда сможем опробовать разные способы борьбы с фальшивыми новостями.

Hoaxy также способна наглядно показать пользователям, как легко с помощью информации из сети манипулировать их мнением — и даже насколько легко многие из нас готовы делиться фальшивыми новостями. Hoaxy станет частью пакета программ нашей Обсерватории социальных медиа, которая позволяет любому человеку проследить за распространением мемов через твиттер. Объединяя воедино такие программы, пользователей, привыкших проверять информацию, и соцсети, можно свести к минимуму дублирование усилий и повысить взаимопомощь между ними.

Очень важно объединить усилия для изучения этих вопросов. Нам нужны все: IT-специалисты, социологи, экономисты, журналисты, — и все партнеры IT-индустрии должны сотрудничать, чтобы поставить заслон распространению дезинформации.

автор

Профессор вычислительной техники и информатики; Директор Центра сложных сетей и системных исследований, Университет Индианы, Блумингтон

https://theconversation.com/misinformation-on-social-media-can-technology-save-us-69264